Vidéo, de la prise de vue à l’archivage

Les spécificités de la numérisation de la vidéo

La vidéo présente des particularités spécifiques dont il faut tenir compte pendant la numérisation pour produire une copie numérique aussi fidèle à l’original que possible. Ceci présuppose une large connaissance de la technique d’enregistrement, de production et de projection.

En cas de collaboration avec un prestataire de service, ce dernier doit être prêt à indiquer ses outils de travail, à expliquer les chemins du signal et les procédures, à les discuter et à les inclure dans un contrat de travail. De même, ses installations doivent pouvoir être inspectées car les in formations disponibles sur son site web sont généralement insuffisantes. Notre publication a pour but de vous rendre attentif à quelques particularités de la numérisation de la vidéo, qu’il vous faudra toujours discuter avec un prestataire.

Il vaut toujours mieux éviter toute perte de qualité pendant la numérisation même, car, par la suite, ces pertes ne peuvent être corrigées que superficiellement par des moyens numériques. Pour la numérisation, il faut donc choisir des dérouleurs de bande magnétique qui tireront le meilleur de la substance encore existante sur le support analogique. Pendant la durée de vie d’un format vidéo, des progrès techniques considérables ont souvent été faits, qui ont permis, dans les spécifications de format fixées initialement, une diminution remarquable du « bruit de l’image » (le « bruit » d’un signal est la superposition à celui-ci d’une erreur liée au procédé physique utilisé), une résolution et une stabilité de l’image améliorées. C’est pourquoi les appareils de la dernière génération se prêtent en règle générale le mieux pour une numérisation, surtout s’ils comptent un nombre aussi restreint que possible d’heures de fonctionnement (de leurs têtes vidéo en particulier) et s’ils ont été entretenus régulièrement ou peu de temps avant leur utilisation. Même des appareils qui sont restés longtemps inutilisés, avec peu d’heures de fonctionnement, peuvent avoir subi des détériorations dues à leur inutilisation ! Pour un format particulier, les appareils industriels professionnels sont objectivement préférables aux appareils destinés au grand public, mais seulement à l’intérieur d’un certain intervalle de temps lié à leur durée de fabrication et seulement pour les modèles les plus récents. Dans les formats Video8/Hi8 et dans la famille VHS, il arrive que les meilleurs appareils grand public, de dernière génération, offrent, pour un format donné, une qualité d’image visiblement supérieure à celle des appareils professionnels plus anciens de 15 à 20 ans. Une comparaison visuelle critique de la qualité de l’image pour les appareils disponibles peut être utile si le budget ne permet ni acquisition ni remplacement de matériel.

En ce qui concerne les très vieilles bandes magnétiques, le réglage de l’alignement de la tête doit être fait très soigneusement pendant toute la durée du repiquage, si possible avec le monitoring du signal FM (= du son) depuis la tête vidéo ou du moins au moyen de la mesure de l’intensité du signal (= du son) avec un affichage correspondant.

La condition préalable est que le matériel soit en bon état : si la bande grince ou si l’image est extrêmement instable horizontalement ou verticalement, ou que l’image est perturbée jusqu’à générer un effet de neige (des points blancs apparaissent et disparaissent de l’image), on est alors face à des dommages liés au vieillissement de la bande et celle-ci doit être traitée avant la numérisation. La numérisation peut être plus ou moins difficile, mais ce qui importe avant tout, c’est que l’information stockée sur la bande soit d’une intensité suffisante pour pouvoir être lue ; selon les caractéristiques physiques de la surface de la bande, la lecture sera plus difficile voire impossible. Tant que la pellicule ne se détache pas du support, la probabilité de lire l’information reste toutefois forte.

Même si une bande vidéo ne laisse extérieurement reconnaître aucune marque de vieillissement, il faut la passer avant la numérisation à travers une machine de nettoyage (nommée Tape Evaluator) qui nettoie et lisse la surface supérieure de la bande (une lame de saphir au bord arrondi polit la bande). On trouvera les appareils pour les familles de format U-matic, VHS et Betacam chez le fabricant RTI. Le temps de passage par bande est de quelques minutes ; dans la mesure où les machines de nettoyage sont chères, on n’hésitera pas à comparer coût d’acquisition et prestation externalisée.

Pour des raisons d’éthique professionnelle, l’intégrité du signal sera conservée lors de la restauration. Ceci exclut le recours à un déguisement numérique ou à un changement d’échelle, qui permet de dissimuler les bords flottants latéraux ou les changements de tête de lecture visibles sur les bords inférieurs. Ceci est valable même si ces bords flottants étaient par le passé moins visibles à cause des bords de l’appareil devant le moniteur à tube cathodique. L’intégrité du signal interdit aussi tout procédé de désentrelacement de l’affichage des images pour le transformer selon le procédé à balayage progressif (= passer de 50 demi-images à la seconde à 25 images entières par seconde). De vilaines structures en dents de peigne, qui déforment l’image lors des mouvements, en sont ici la conséquence. Pour atténuer ces effets, il ne faut pas non plus diviser la résolution verticale de moitié, en ne tenant compte que d’une demi-image sur deux. Lors de la numérisation, il faut régler la position latérale de l’image de telle façon que l’image (analogique) soit toujours exactement centrée dans la fenêtre numérique. Dans de nombreuses productions analogiques, la position latérale peut aussi sauter de scène en scène. Une numérisation poussée en tiendrait compte et chercherait à corriger les sauts de côté, ce qui par ailleurs nécessite plusieurs itérations passes. Les sauts sont clairement des défauts techniques datant de la production et, en ce sens, historiques mais ils ne sont pas forcément dignes d’être conservés.

Tout masquage ou élargissement latéral (coupure, panning), tout écrasement ou extension de l’image à des fins d’adaptation du vieux rapport 4:3 au format actuel 16:9 sont des modifications non autorisées. Les bandeaux noirs sur les côtés latéraux de la nouvelle image doivent être acceptés : ils sont les témoins d’un changement de culture et de technologie, lequel doit rester visible. Ceci vaut aussi bien pour la numérisation que pour toute autre utilisation (projection, diffusion, édition, etc.). Le master destiné aux archives et à la conservation de longue durée ne doit pas seulement conserver le rapport original mais aussi le nombre de lignes par (demi)image. Un arrondi vers le haut porterait atteinte à l’intégrité du signal. Il en va de même à la lecture des pixels des sources numériques natives, dont le nombre doit être respecté.

Un Time Base Corrector (TBC) s’avère généralement indispensable pour stabiliser une image vidéo analogique, parce que de nombreux convertisseurs A/D, surtout dans le domaine professionnel, traitent mal les signaux instables et, par ex., omettent ou bloquent certaines images. Pour les très vieux formats (bobines ouvertes) ou les bandes U-matic éditées dans les années 1970 sans verrouillage des couleurs, il peut s’avérer nécessaire de recourir simultanément à deux TBC : un ancien, capable de tolérer les instabilités historiques (plus grande tolérance dans le timing des signaux, variation brusque de la teinte colorimétrique), et un TBC moderne, qui évite les effets de moiré et qui adapte le signal, peut-être encore trop instable, issu du TBC d’époque aux tolérances plus étroites du convertisseur. La gigue électronique ou fluctuation latérale du signal (« Jitter » en anglais), les variations et autres instabilités de tout type ne peuvent plus être corrigées dès la sortie du signal du TBC, parce qu’elles font désormais partie de l’image reconstituée avec de nouveaux signaux, stables, de synchronisation. Choisir le bon TBC revêt donc une importance cruciale, exige d’avoir de l’expérience et d’échanger son expérience avec d’autres professionnels. L’utilisation du TBC historique adéquat peut – indépendamment du signal nécessitant une stabilisation – s’avérer nécessaire mais ne doit en aucun cas être envisagée comme une panacée. Ici aussi, d’impressionnantes évolutions techniques ont eu lieu, qui ont une incidence sur la structure de l’image. La règle est donc : ne prendre du vieux matériel qu’en cas de nécessité, et opter pour du matériel moderne tant que possible.

Les possibilités de réglage du TBC (clarté, contraste, saturation de la couleur) doivent être utilisées avec savoir et prudence. Il ne faut en aucun cas adapter le signal d’une image ancienne, grise et terne, aux contrastes modernes de couleur, auxquels les médias numériques nous ont habitués. Une bonne connaissance des œuvres et des documents de tous les âges de l’image électronique est indispensable pour procéder à des réglages respectant la réalité historique. Des adaptations modérées, s’en tenant à l’amplitude de contraste techniquement possible – et le plus sou vent aussi atteignable – du canal vidéo, peuvent d’ailleurs faire sens. À cette fin, un moniteur de forme d’onde est en tous le cas nécessaire, afin de visualiser graphiquement et interpréter le signal vidéo (luminance mais aussi chrominance). Lors des réglages de contraste et de luminosité, il faut être attentif à ne pas couper la moindre partie du signal, tout particulièrement les plages très lumineuses ou des sections de faible intensité (en allemand, « des sections de bruit ») proches du noir. Le signal serait alors irrémédiablement perdu, ce qui n’est en aucun cas tolérable, même si l’effet visuel en est prétendument amélioré. Très bientôt, les images des vieilles vidéos ne pourront, elles aussi, n’être visionnées que sur des écrans plats ou en projection. Ce matériel moderne n’offrira plus de véritables possibilités de correction de la luminosité et du contraste, contrairement aux anciens moniteurs à tubes cathodique, qui pouvaient encore être adaptés au matériel de projection. Cette réalité plaide aussi pour un renforcement du contraste (une diminution ne fait jamais sens) comme seule adaptation.

Ces remarques se rapportent au matériel vidéo qui n’a pas été produit moyennant un équipement professionnel, i. e. disposant d’un éclairage solide de studio et d’un signal respectant à la prise de vue, les valeurs recommandées par les normes. Depuis des décennies, des valeurs standardisées permettent sans autre une projection sur des écrans modernes.

Lorsque des adaptations du contraste et de la luminosité sont faites, elles devraient l’être de façon circonspecte et responsable, sans forcément repousser les limites du techniquement possible. Les traces d’imperfections techniques lors de la production ne doivent pas être effacées – elles font partie intégrante de la substance historique de la source. Ces imperfections doivent aussi être suffisamment documentées à l’aide d’exemples (copies d’écran du moniteur de forme d’onde (waveform) avec et sans correction, fichier vidéo avec de courts extraits avec et sans correction ; copier les valeurs chiffrées des boutons de réglage n’a par contre pas de sens). Si aucune partie de signal n’est coupée, ces mesures pourraient ainsi être rendues réversibles sur la base de la documentation.

Si un appareil de lecture dispose d’un TBC intégré et que ce dernier est compatible, on peut alors comparer les variantes entre TBC intégré et externe. Si le TBC intégré offre de plus une possibilité d’atténuer le bruit, celle-ci doit être aussi comparée de façon critique avec un traitement externe.

Depuis que la possibilité d’atténuer le bruit existe dans le domaine de la vidéo, elle fait l’objet de discussions et de controverses. Dans le domaine audio, utiliser un filtre de fréquence, qui sert à amplifier le signal pour chaque fréquence, est une pratique courante depuis longtemps. Dans la numérisation, ce n’est absolument pas le cas, ou seulement a posteriori, en fonction de l’usage prévu. Dans le domaine vidéo, la place de stockage était jusqu’à présent trop chère et la dépense trop importante, pour fabriquer une copie numérique « brute » (i.e. ni modifiée ni retouchée, soit un brut de scan) sans diminution de bruit, avec l’option d’un traitement postérieur. La maxime de l’intégrité du signal s’oppose à la diminution du bruit – car toute diminution du bruit de l’image entraîne une modification ou une perte de détails de l’image, qui sont ainsi irrémédiablement perdus. La diminution du bruit se justifie par le fait que, dans l’historique de la bande, une partie du bruit a été produite par des processus souvent répétés de copie et que la procédure veut rendre le résultat proche de la forme originale. Si le contenu par ex. doit être diffusé sur un support DVD, vu la forte compression inhérente à ce dernier, alors la diminution du bruit est nécessaire, pour éviter l’apparition d’artefacts disgracieux. Le coût horaire élevé du traitement postérieur et les coûts de stockage, au minimum doublés, exigeaient jusqu’ici en règle générale une décision avant la numérisation.

Si l’on entreprend de diminuer le bruit, le recours à un TBC moderne et de haute qualité est recommandé, afin d’annuler simultanément et relativement efficacement les drop-outs (petites pertes d’information) qui dérangent. Grâce au passage de la télévision et de l’industrie à la HD, il est désormais possible d’acquérir des appareils SD à des prix avantageux. Ces appareils permettent de régler la diminution du bruit de façon différenciée, laquelle, en dépit des tentations, devrait être effectuée avec circonspection.

Si les ressources à disposition sont suffisantes et qu’une copie numérique, brute de scan, est prévue, le bruit peut alors être a posteriori diminué par une solution hardware ou software. Le TBC commercialisé sous le nom de TBS 180/185 a des entrées et sorties numériques et sa compensation de Dropout fonctionne aussi depuis le disque dur avec un signal déjà numérisé (lu par la connexion SDI [Serial Digital Interface]), contrairement aux compensateurs de Drop-out plus anciens, qui ne travaillaient qu’à partir de sources ana logiques et encore généralement pas de façon satisfaisante. Une compensation de Dropout parfaite a posteriori pourrait être atteinte en temps réel et sans pertes issues de la conversion (grâce à la connexion SDI) au moyen de deux ordinateurs et de leurs convertisseurs A/D respectifs, et ceci à des coûts qui ne représentent qu’une infime partie de ceux liés à une solution software et hardware de restauration numérique de la vidéo. En cas de moyens limités, l’alternative à cette solution, non conventionnelle – nous l’accordons –, peut-être de recourir à un plug-in de débruitage (par ex. Neat Video) pour des programmes usuels comme Premiere ou FinalCut, avec lesquels on numérise déjà en règle générale. A relever que le temps de calcul peut alors être plus élevé, d’où une baisse de productivité. De même, l’algorithme pour l’élimination des dropout semble être moins performant. Dans le dernier procédé décrit ici, une numérisation sans compression s’avère indispensable, sur au moins 10 bits. Elle est recommandée aujourd’hui de toute façon parce que plusieurs dérivés sont en règle générale créés à partir de la copie numérique brute de scan, qu’elle soit filtrée ou non : les fichiers d’archivage, les copies commerciales ou de visionnement peu compressées, le fichier pour streaming plus fortement compressé destiné à l’usage interne ou la distribution en ligne. Il s’agit de modéliser les étapes d’un traitement approprié, qui laisse la possibilité de produire les dérivés correspondants dans un futur proche ou plus lointain.

La décision de créer des fichiers compressés ou non compressés pour l’archivage dépend du contexte (entre autres quantité, valeur, ressources disponibles) mais aussi de la qualité initiale du matériel. Néanmoins et c’est tout le contraire de ce qu’on suppose souvent : les images perturbées par du bruit sont difficiles à traiter par n’importe quel compresseur, car le bruit est une « information » imprévisible, alors que la compression repose, elle, sur des structures d’images prévisibles et itératives. Une bande VHS floue et très perturbée par le bruit se prêtera ainsi paradoxalement mieux à une compression moindre qu’une bande Betacam SP avec une image produite avec un éclairage professionnel et captée avec un trépied (à condition que leur importance historique puisse être comparée sur la base du contenu).

La prise de décision pour ou contre une compression devrait, indépendamment des aspects déjà mentionnés, comprendre aussi la sécurité à long terme, un point pour lequel un fichier non compressé donne de meilleurs résultats.

Formats vidéo recommandés

Aucun standard uniforme ne s’est imposé au niveau international pour la numérisation des vidéos à des fins d’archivage numérique. Bien au contraire, le consensus entre professionnels est toujours plus grand pour affirmer que le choix du codec, du conteneur et des paramètres techniques (débit, résolution de l’image etc.) dépendra du contexte (concept de conservation, concept d’utilisation etc.). Ce chapitre présente donc différents contextes possibles et les recommandations concrètes sur le choix des formats – ceci pour des scénarios très simplifiés qui peuvent se présenter dans toutes les variantes et combinaisons possibles, sans recouvrir toutes les situations possibles. Ces scénarios doivent servir d’angle d’attaque pour l’orientation. Le postulat de départ est qu’un format doit être sélectionné, qu’aucun format déjà disponible ne peut être archivé et qu’un standard interne n’est pas déjà défini par le service d’archives.

Exemple 1 : caractère documentaire

Un service d’archives désire numériser, respectivement (faire) convertir en fichiers le contenu purement documentaire d’une grosse collection de cassettes VHS, Beta-SP et MiniDV. Les exigences en matière de conservation des propriétés techniques et visuelles (comme la restitution des couleurs) sont relativement modestes : c’est la conservation du contenu transmis qui prime, non l’impression visuelle. Il n’est pas prévu non plus d’utiliser les documents vidéo pour de nouvelles productions ou d’ambitieuses expositions. De plus, les documents audiovisuels ne sont pas une spécialité du service d’archives : celui-ci ne dispose ni du personnel spécialisé ni d’infrastructures et de moyens financiers particuliers pour répondre aux exigences spécifiques de l’archivage numérique de documents audiovisuels.

Dans pareil cas, la numérisation en format DV PAL et l’archivage numérique sous forme de fichiers DV ou MXF (fichiers DV et métadonnées comprises) pourraient être recommandés en précisant que le format DV travaille avec une forte compression, laquelle peut conduire à des pertes d’information et créer, selon l’état des originaux, des artefacts qui feront partie de l’objet numérisé. Le format DV présente les avantages suivants : large diffusion ; spécifications standardisées par SMPTE (Society of Motion Picture and Television Engineers) ; manipulation simple qui permet au service d’archives non spécialisé de traiter lui-même les copies d’archives. Enfin, les fichiers obtenus sont relativement petits et le volume de données est relativement minime pour la vidéo (environ 13 GB / heure). Dans la prise de décision qui peut mener au choix de ce compromis, il faudra être conscient des désavantages, les peser clairement et, en tant qu’archiviste, les justifier du point de vue de la déontologie professionnelle. Le format DV travaille en effet avec une très forte compression qui cause des pertes d’information et qui produit des artefacts dès la numérisation déjà (selon l’état de l’original), ce qui peut avoir comme conséquence que des artefacts supplémentaires seront créés lors des prochaines migrations.

Exemple 2 : solution sans compromis

L’archivage de l’art numérique peut être présenté pour le cas de la solution sans compromis. Indépendamment du type de support original, les œuvres doivent en effet pouvoir être conservées sur la longue durée sans souffrir la moindre perte. Le nombre d’œuvres concernées n’est pas énorme mais il importe absolument que leur restitution, et particulièrement la forme visuelle, soient absolument fidèles, c’est pourquoi le débit /fréquence / taux d’échantillonnage, la fréquence de répétition des images, le sampling couleur, la méthode de scan (balayage entrelacé ou progressif) etc., tout doit correspondre à l’original.

Dans ce cas, les formats 8 ou 10 bits, 4:2:2, non compressés (V210) et 10 bits, 4:4:4 non compressés (v410, pour HD) peuvent être recommandés comme codecs, en fonction de l’infrastructure disponible ou prévue, dans des conteneurs comme MXF, MKV ou MOV. Le volume de données est cependant relativement important (100–780 GB/heure) et les coûts de conservation, conséquents, exigent une très bonne planification. L’avantage réside dans le recours à des standards établis et techniquement assez simples et peu exigeants.

Exemple 3 : compromis progressif

Un service d’archives désire migrer des enregistrements vidéo existants sur DigiBeta ou HDCam et (faire) produire des fichiers pour l’archivage. Ces derniers doivent répondre à des exigences plutôt élevées, de plus les pertes en information et en qualité d’image de ces enregistrements de très bonne qualité doivent être évitées afin de ne pas limiter les possibilités d’utilisation future. Les moyens financiers disponibles pour l’archivage numérique sont cependant très limités et exigent une solution où le volume de donneés est un facteur très critique.

Pour pareil cas, des codecs de compression sans perte (« lossless ») comme FFV1 (version 3) ou Motion JPEG 2000 (lossless) pourraient être recommandés afin que la quantité de données puisse être réduite au tiers de son volume sans perte d’information (environ 30–50 Go/heure). Il faut être conscient, dans le choix de ce compromis progressif, que ces codecs exigent actuellement encore relativement beaucoup de savoirfaire spécialisé (Open Source Software), et qu’une grande puissance de calcul est nécessaire pour MJ2K ; enfin, leur développement est encore en cours. Pouvoir garantir la mise à disposition d’un personnel spécialisé ou / et l’existence d’une très bonne relation avec une personne prestataire externe est donc nécessaire pour prendre pareille décision.

Lorsque cette condition préalable est remplie, on peut par exemple recommander aujourd’hui le format FFV1 dans un conteneur MKV. JPEG 2000 (lossless) dans MXF peut être recommandé si l’infrastructure nécessaire, soit de puissantes solutions software et hardware, est disponible.

Les recommandations pour les formats de copie d’utilisation (film et vidéo) se trouvent dans le chapitre Film et vidéo: accès et mise en valeur.

Codecs et transcodages

Les transcodages (conversion des données d’un codec à un autre) sont faits pendant le déroulement de la production d’une vidéo pour adapter le format du fichier aux exigences de l’étape de travail où il se trouve. Les exigences requises par l’archivage et par les étapes précédentes de la production ne se recouvrent généralement pas. La production d’un document audiovisuel ne génère donc pas automatiquement des fichiers archivables. Leur archivage peut nécessiter des transcodages.

Principes du transcodage

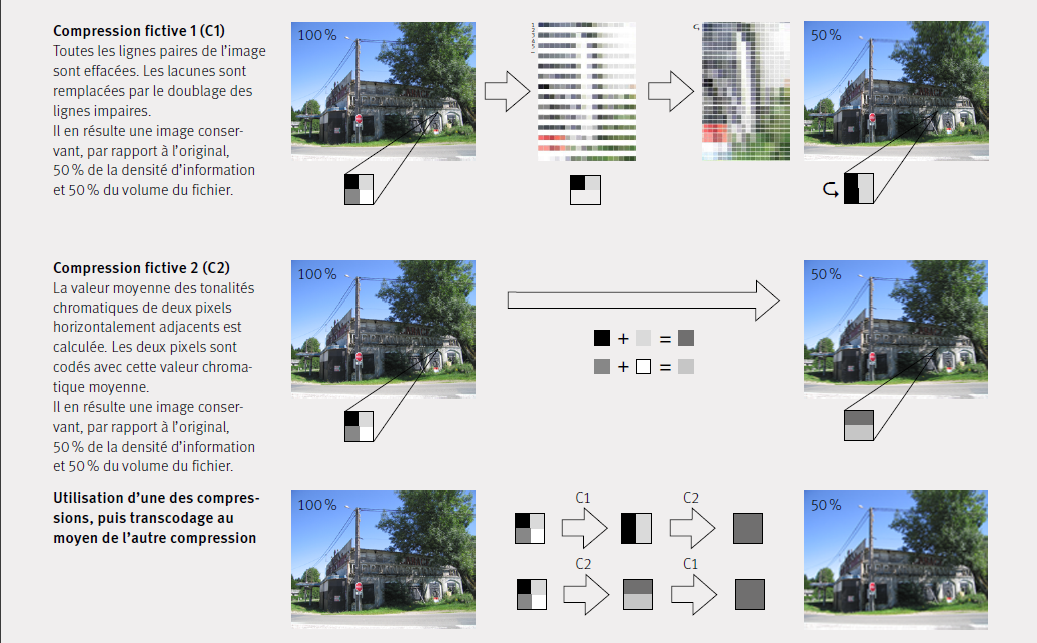

Les caractéristiques des codecs dépendent chaque fois de leur procédé de compression et ces propriétés sont optimisées pour tel ou tel domaine d’application. Comme les fichiers vidéo non compressés génèrent de très grosses quantités de données, leur réduction par la compression est un aspect important, qui justifie des compromis sur la qualité. Les plus gros compromis sont faits à chaque fois là où, en fonction du domaine d’application, ils dérangent le moins. Lors d’un transcodage d’un codec à un autre, la combinaison des différents modes de compression peut avoir des effets négatifs sur les données. Même en cas de conservation d’une taille de fichier identique, l’image peut subir une perte d’information, si les codecs emploient différents procédés de réduction des données. Ill. 2 montre la représentation abstraite des problèmes de qualité que peuvent causer les transcodages d’images. C’est se tromper que de considérer un transcodage comme sans problème lorsque les deux codecs réduisent la quantité de données à partir du même original et dans la même proportion. Employer les deux compressions en cascade provoque une perte d’information drastique. L’image qui en résulte a une densité d’information réduite de 25 % en comparaison avec l’original, parce que les compressions procèdent différemment, dans une «ignorance» réciproque. Ceci a aussi pour conséquence que la taille du fichier après le transcodage ne correspond pas à 25 % du fichier original mais à 50 %. En clair, le transcodage répété fait perdre de l’information et ce sans gain d’espace de stockage.

Les transcodages dans le domaine de l’archivage ont pour principale utilité de convertir des fichiers originaux, qui ne sont pas ou plus archivables, dans des fichiers archivables. Selon le concept de conservation mis en place, réduire le nombre de formats à gérer peut également être un but des transcodages. Un service d’archives peut cependant aussi retenir plusieurs formats de fichiers et établir différentes classes prioritaires de fichiers vidéo : les éléments les plus prioritaires seraient ainsi, par ex., stockés sans compression, tandis que les éléments moins prioritaires seraient stockés dans un format de fichier permettant d’économiser de l’espace mais néanmoins toujours archivable. Les transcodages peuvent aussi être reportés jusqu’à ce qu’ils deviennent inévitables (par ex. suite à un problème d’obsolescence), afin d’éviter des migrations non nécessaires. Cette dernière option dépend beaucoup de la veille systématique et conséquente des développements technologiques.

Un autre exemple classique du transcodage est la conversion entre les normes PAL et NTSC (National Television System Committee, standard états-unien de codage analogique de la vidéo). Cette conversion entraîne cependant beaucoup de modifications :

Le DV PAL, par ex., a le format 4:2:0 avec une image de 720×576 pixels rectangulaires et un rapport largeur/hauteur de 16:15. Le DV NTSC a le format 4:1:1 avec une image de 720×480 pixels rectangulaires et un rapport largeur/hauteur de 8:9.

La fréquence d’images (nombre d’images par seconde) doit, elle aussi, être modifiée, passant de 50 à 60 demi-images par seconde et l’espace chromatique doit être adapté.

Pour résumer, les recommandations suivantes doivent être suivies : Il faut entreprendre aussi peu de transcodages que possible, en préférant des cycles de migration longs, pour minimiser les problèmes. Chaque transcodage crée des artefacts car la problématique est semblable à celle rencontrée pour les changements de génération dans le domaine de la vidéo analogique.

Les transcodages doivent être bien documentés et attestés dans les métadonnées, car ces informations pourront être employées lors de prochains transcodages pour éliminer ou atténuer des problèmes. De plus, l’historique des transcodages antérieurs ne peut en général malheureusement plus être retracé lors du transfert des éléments numériques dans le service d’archives.

En principe, aucun transcodage ne devrait avoir lieu dans l’institution patrimoniale, qui puisse réduire avec perte le volume de données. Le transcodage dans un codec de compression avec perte entraîne une perte d’information, en particulier quand ce processus réduit la quantité des données.

La prudence est aussi recommandée lors d’un transcodage vers un codec équivalent. En effet, même si le volume de données reste identique, des pertes d’information peuvent avoir lieu avec des codecs de compressions avec perte, si les modes de compression des codecs sont difficilement compatibles.

La qualité des données à disposition ne peut pas être améliorée en opérant un transcodage au moyen d’un codec de compression à perte réduite : dans le meilleur des cas, la qualité reste identique. Le transcodage dans un format de fichier un peu moins compressé peut néanmoins améliorer les résultats de futurs traitements et augmenter l’archivabilité des données.

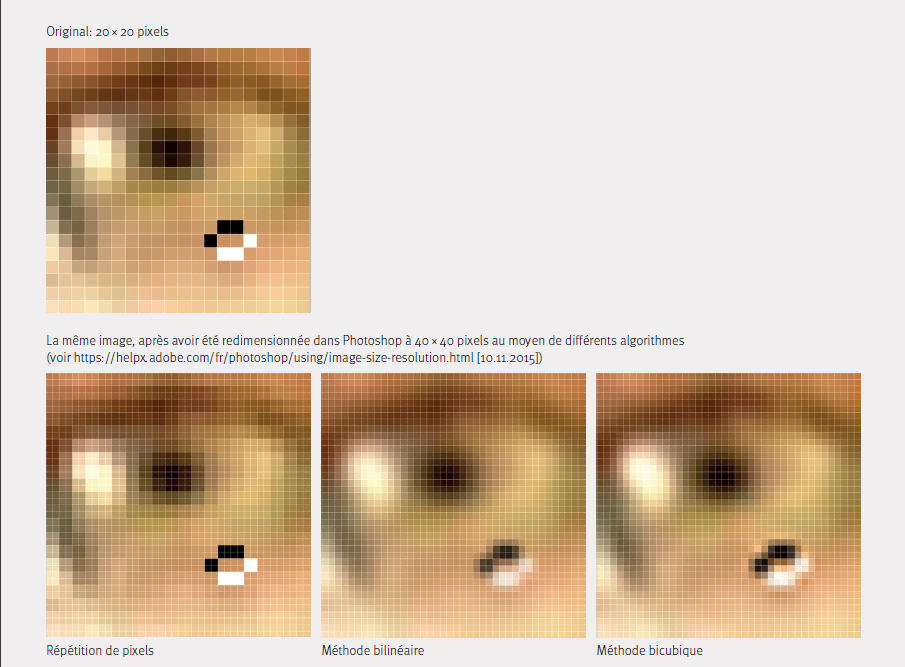

Un changement d’échelle des images numériques dans une résolution plus élevée est aussi un transcodage. Les changements d’échelles d’une résolution basse SD à une résolution haute HD sont courants dans le domaine vidéo et sont considérés comme non problématiques, puisque, pour ainsi dire, seule la surface de l’image est agrandie. On suppose que la structure de l’image est conservée, voire améliorée, et qu’aucune réduction du volume de données n’a lieu. Ceci est cependant une conclusion erronée. Chaque pixel de l’image est touché par un changement d’échelle : des pixels supplémentaires sont de fait « inventés » (c’est-à-dire calculés en fonction des pixels voisins). Il existe différents algorithmes, dont les résultats divergent considérablement [> illustration no 24, p. 76 Link zur Illustration].

L’objectif, et ceci vaut particulièrement pour l’art vidéo, doit être de conserver la structure de pixels de l’original pendant toutes les étapes du traitement de conservation, exactement comme lorsqu’on s’efforce de présenter dans une exposition une œuvre dans des conditions aussi fidèles que possible au contexte original.

Particulièrement problématiques sont les cas où le changement d’échelle fait passer les images d’une résolution basse SD (Standard Definition) à une résolution haute HD (High Definition), de sorte que le matériau est si fortement compressé que le fichier HD est plus petit que le fichier SD originel. Dans ce cas, la structure de l’image est modifiée massivement et irrémédiablement, une première fois par le changement d’échelle, puis encore une fois par la compression.

L’objectif, et ceci vaut particulièrement pour l’art vidéo, doit être de conserver la structure de pixels de l’original pendant toutes les étapes du traitement de conservation, exactement comme lorsqu’on s’efforce de présenter dans une exposition une œuvre dans des conditions aussi fidèles que possible au contexte original.

Particulièrement problématiques sont les cas où le changement d’échelle fait passer les images d’une résolution basse SD (Standard Definition) à une résolution haute HD (High Definition), de sorte que le matériau est si fortement compressé que le fichier HD est plus petit que le fichier SD originel. Dans ce cas, la structure de l’image est modifiée massivement et irrémédiablement, une première fois par le changement d’échelle, puis encore une fois par la compression.

Outils de transcodage des fichiers mediamédia

Ces applications facilitent le transcodage : FFmpeg, FFmpeg Batch A/V Converter

Dernières modifications: avril 2023